Una nueva investigación ha comprobado que los sonidos se pueden usar para que personas inmovilizadas pero conscientes puedan comunicarse con los médicos, familiares y amigos. Funcionó con éxito en un paciente de ELA que ya ni podía mover los ojos.

Un hombre con Esclerosis Lateral Amiotrófica (ELA), que estaba completamente paralizado e incapaz de abrir y controlar sus ojos voluntariamente (un estado conocido como el síndrome de cautiverio o CLIS), pudo juntar palabras y frases para comunicarse a una velocidad promedio de aproximadamente un carácter por minuto, usando solamente los sonidos.

Esta proeza fue posible gracias al uso de una interfaz neuronal invasiva que se basaba en la modalidad auditiva en lugar del movimiento ocular. El artículo que relata esta experiencia ha sido publicado en la revista Nature Communications.

Los pacientes con ELA sufren parálisis muscular progresiva. A medida que avanza la enfermedad, pierden la capacidad de respirar debido a la parálisis del diafragma.

Con la transición a la ventilación mecánica y la parálisis de los músculos faciales, los pacientes, en la mayoría de los casos, ya no pueden hablar y experimentan el síndrome de "persona encerrada en su propio cuerpo": no pueden moverse ni hablar, pero permanecen conscientes.

Sin movimiento ocular

Además, estos pacientes pueden conservar el control de los ojos, el parpadeo y la capacidad de dirigir y fijar la mirada. Usando este control no perdido sobre el movimiento de los ojos, la comunicación del paciente con el mundo exterior por lo general se puede establecer con éxito a través de interfaces cerebrales, tanto invasivas como no invasivas.

Pero tan pronto como el paciente pierde también el control del movimiento de los ojos y ya no puede abrirlos voluntariamente, ningún sistema puede ayudarlo a mantenerse en contacto con el mundo exterior (esta condición se denomina síndrome de "cierre total" con el mundo exterior).

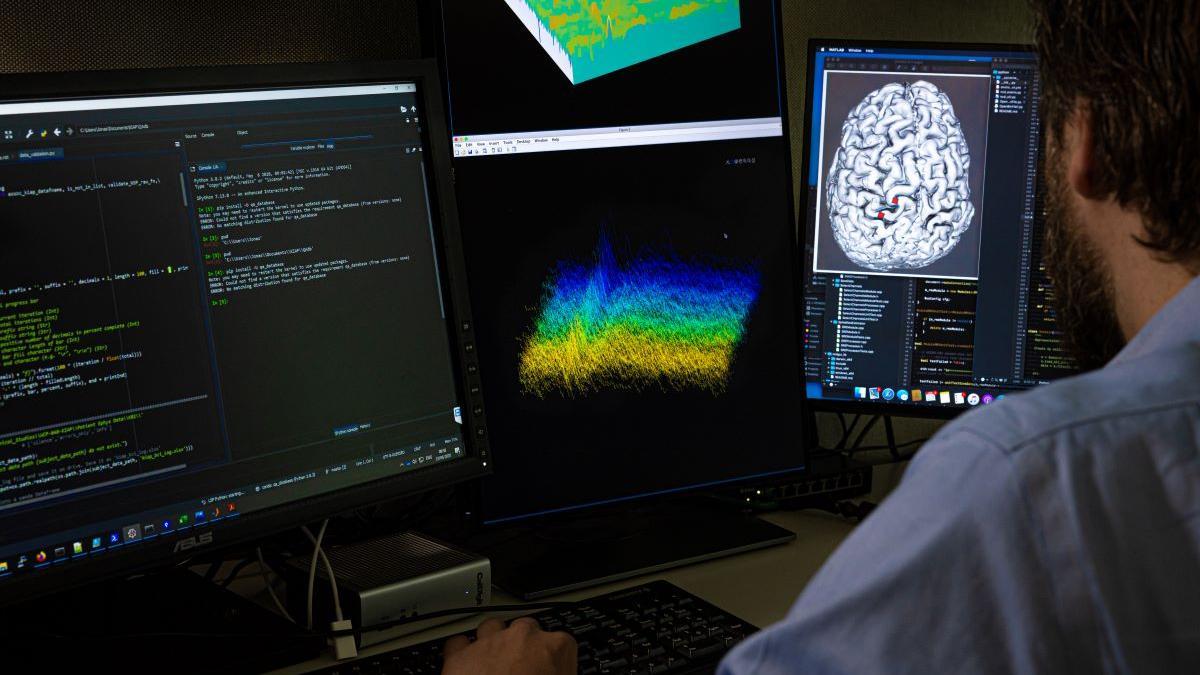

Para volver a conectar con el mundo exterior a un hombre de 34 años que ya no podía controlar el movimiento de los ojos ni la mirada, Jonas Zimmermann, del Centro Wyss de Bioingeniería y Neuroingeniería en Ginebra, y sus colegas, implantaron dos conjuntos de 64 microelectrodos en la corteza motora del paciente.

Un día después de la implantación, los investigadores intentaron establecer una conexión con el paciente. Primero, se le pidió que usara la forma previamente efectiva de responder "sí" y "no" usando movimientos oculares, y los científicos intentaron detectar la diferencia en la actividad cerebral que acompañaba al movimiento ocular correspondiente. Pero no se pudo encontrar ninguna diferencia en la frecuencia de la actividad observada.

Audio biofeedback

En el día ochenta y seis después de la implantación, los científicos decidieron utilizar la modalidad de biorretroalimentación auditiva para interactuar con el paciente.

La biorretroalimentación (también conocida como biofeedback) es una técnica que permite tomar consciencia de una serie de procesos del organismo de los que no somos conscientes.

Para realizar el biofeedback se requiere un sistema que emita señales cuando la persona reacciona ante un estímulo. Esta técnica ha generado una forma de entrenamiento cerebral denominada neurofeedback, a través de la cual un aparato mide la actividad cerebral, la analiza y la da a conocer al paciente para que sea consciente de ella y, en el caso de esta investigación, pueda utilizarla para comunicarse.

Neurokey

El aparado utilizado en esta investigación, conocido como NeuroKey, es un interfaz cerebro-ordenador que incluye un decodificador de señales neuronales y un deletreador basado en audiofeedback.

Usando esta técnica, el paciente, tras identificar el tono y la frecuencia del biofeedback recibido, aprendió a comparar la frecuencia de la actividad neuronal con la frecuencia de las ondas sonoras y a establecer con ellas normas ortográficas de comunicación.

A continuación, empleó una estrategia solo guiada por el oído, con los ojos cerrados, para comunicarse a través de las ondas sonoras, que según su frecuencia eran interpretadas por Neurokey como un "sí" o como un "no", ante cualquier pregunta.

A partir del día ciento seis, pudo usar este método para seleccionar letras, primero una cada vez, y luego juntarlas en palabras y frases, y así comunicar sus necesidades y experiencias.

Reencuentro con la familia

Los mensajes legibles del paciente constaban de 5.747 caracteres generados durante un período de 5.338 minutos, lo que corresponde a una tasa promedio de 1,08 caracteres por minuto.

De esta forma, pudo escribir correctamente su nombre, los nombres de su esposa e hijo y dar las gracias a los investigadores por su trabajo, a través de las ondas sonoras. También pudo informar algo sobre los cuidados necesarios, por ejemplo, pedir cambiar la posición de la cabeza y el cuerpo, y expresar así sus deseos.

Incluso pudo invitar a alguien a visitarlo por la noche para escuchar un álbum de música, y también se ofreció a mejorar el sistema pidiéndole a los investigadores que "activaran el reconocimiento de palabras" el día 183 después de la operación.

Y el día 247, el paciente dejó una reseña sobre el sistema: “chicos, funciona y es fácil”. Además, la implantación de electrodos y el dominio de la interfaz de retroalimentación auditiva le permitieron recuperar la comunicación con los miembros de la familia.

También en casa

Los investigadores observaron al paciente en sesiones diarias de comunicación con él a través de la interfaz neural, a partir del día 106 hasta los 462 días después de la implantación de los electrodos.

Al mismo tiempo, durante todo este tiempo, el participante vivía en casa con su familia, y los científicos acudían a su casa para realizar investigaciones.

Es decir, este estudio también demostró que, con la participación de la familia o cuidadores, el sistema puede en principio ser utilizado en casa. Y este es un punto importante para las personas que viven con ELA y son atendidas fuera del entorno hospitalario.

Los autores señalan que será necesario implementar varias modificaciones de software y hardware en el futuro antes de que la familia o los cuidadores puedan usar el sistema por su cuenta.

Referencia

Spelling interface using intracortical signals in a completely locked-in patient enabled via auditory neurofeedback training. Ujwal Chaudhary et al. Nature Communications, Volume 13, Article number: 1236 (2022). DOI:https://doi.org/10.1038/s41467-022-28859-8